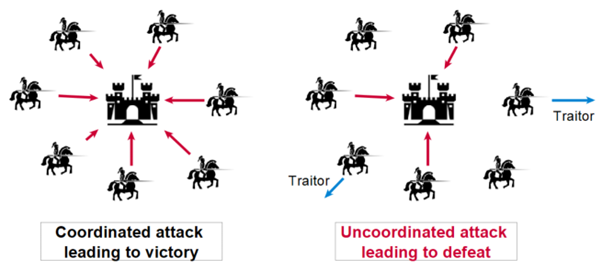

La historia de los mecanismos de consenso comienza con un problema fundamental en la informática: el problema de los generales bizantinos.

Imaginemos varios generales que deben coordinar un ataque, pero que sólo pueden comunicarse mediante mensajeros. Algunos generales pueden ser traidores y los mensajeros pueden ser interceptados. ¿Cómo nos aseguramos de que todos los generales leales tomen la misma decisión? Esta metáfora militar sirve como base para ilustrar los desafíos que enfrentan los sistemas distribuidos modernos.

Los primeros trabajos sobre este problema, realizados en la década de 1980, sentaron las bases teóricas de lo que se convertiría en un área crucial de la informática moderna. Leslie Lamport, pionera en este campo, demostró que era imposible lograr un consenso de manera determinista en un sistema asíncrono si incluso un solo nodo podía fallar.

Anatomía de un consenso

Un mecanismo de consenso sólido debe garantizar varias propiedades esenciales:

- Todos los nodos considerados “honestos” deben converger hacia la misma decisión. Esta propiedad es inviolable, incluso en caso de partición de red.

- El sistema debe seguir avanzando y tomando decisiones, incluso ante la presencia de fallos o ataques.

- Una vez que se ha tomado una decisión, no se puede reconsiderar. Esta propiedad existe en dos formas: finalidad inmediata y finalidad probabilística.

La finalidad inmediata, que se encuentra en particular en protocolos de tipo BFT como PBFT o Tendermint, garantiza que una vez que una decisión ha sido validada por la red, sea definitiva y no pueda ser cuestionada en absoluto.

Tomemos el ejemplo de una transacción bancaria: cuando su banco confirma que se ha realizado una transferencia, quiere tener absoluta certeza de que esta transacción nunca será cancelada ni modificada. Esta forma de finalidad generalmente requiere un proceso de validación de varios pasos con votos explícitos de los participantes, como si, para tomar una decisión importante, todos los miembros de una junta directiva tuvieran que firmar un documento oficial.

La finalidad probabilística, utilizada en particular por Bitcoin y los sistemas basados en Prueba de Trabajo, funciona de manera diferente. En este caso, la certeza de que una decisión es definitiva aumenta gradualmente con el tiempo. Para tomar el ejemplo de Bitcoin, cuantos más bloques se confirman después de una transacción (hablamos de “confirmaciones”), más improbable estadísticamente resulta que esta transacción sea cuestionada. Es casi como si la confianza en un acontecimiento histórico aumentara con el número de fuentes independientes que lo confirman. Después de seis confirmaciones en Bitcoin (alrededor de una hora), la probabilidad de ver una transacción cuestionada se vuelve infinitamente baja, pero teóricamente nunca es cero.

Modelos de tiempo y fallas

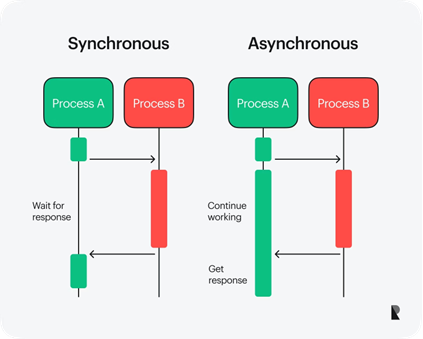

Los sistemas distribuidos se basan en diferentes modelos temporales que modifican su arquitectura y funcionamiento. En un modelo síncrono, el sistema garantiza que cada mensaje se transmitirá en un intervalo de tiempo preciso conocido de antemano, lo que facilita enormemente el diseño de protocolos pero rara vez resulta alcanzable en el contexto actual de Internet, donde los retrasos en la transmisión son impredecibles.

Por el contrario, el modelo asincrónico adopta un enfoque más cercano a la realidad al no hacer suposiciones sobre los retrasos en la transmisión de mensajes, lo que hace que el diseño de protocolos sea más complejo pero más robusto frente a los caprichos de las redes reales. Entre estos dos extremos, el modelo parcialmente síncrono ofrece un compromiso al considerar que el sistema puede pasar por fases en las que se comporta de forma síncrona o asíncrona, adaptándose así a las condiciones cambiantes de la red y permitiendo al mismo tiempo el diseño de protocolos eficientes.

Prueba de trabajo: la revolución de Bitcoin

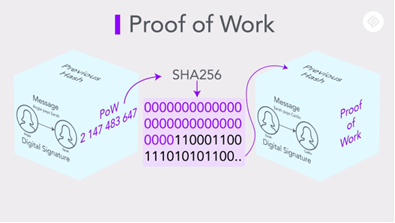

PoW representa una innovación importante porque resuelve el problema del consenso en un entorno completamente abierto y hostil. Su funcionamiento se basa en varios mecanismos sutiles:

La Prueba de Trabajo se basa en tres mecanismos fundamentales que garantizan la seguridad y estabilidad de la red. En el corazón del sistema se encuentra una función hashHash Una función criptográfica que convierte los datos de entrada en una cadena alfanumérica de tamaño fijo. que no sólo debe resistir ataques sino que también debe tener propiedades específicas que lo hagan «amigable con los rompecabezas»: el SHA-256 utilizado por Bitcoin es el ejemplo perfecto. Para mantener la regularidad de la red, un ingenioso sistema automático de ajuste de la dificultad interviene cada 2016 bloques, permitiendo mantener un tiempo medio de 10 minutos entre cada bloque, independientemente de la potencia informática total de la red. Además, para gestionar las divergencias temporales que surgen en una red descentralizada, el protocolo aplica la elegante regla de la cadena más larga, que permite que la red converja naturalmente hacia un consenso favoreciendo la cadena que representa el mayor trabajo acumulado.

Prueba de participación, un nuevo paradigma

En un sistema PoS, los validadores se eligen para verificar las transacciones y agregar nuevos bloques a la cadena de bloques en función de la cantidad de tokens que han apostado. Cuantos más tokens apostados tenga un participante, mayores serán sus posibilidades de ser seleccionado. Por ejemplo, en el caso de Ethereum 2.0, un validador debe apostar al menos 32 ETH para participar en el consenso. Una vez seleccionado, el validador verifica las transacciones del bloque y recibe una recompensa en forma de nuevas criptomonedas o tarifas de transacción.

Este proceso está automatizado mediante algoritmos que seleccionan validadores según criterios predefinidos. Estos criterios generalmente incluyen:

- La cantidad apostada: cuantos más tokens tenga un usuario, más probabilidades tendrá de ser elegido.

- Antigüedad: Algunos sistemas favorecen a los validadores que llevan mucho tiempo participando en la red.

- Aleatorización: para evitar una centralización excesiva, a veces se introducen elementos aleatorios en el proceso de selección.

Un ejemplo concreto es el de Tezos, donde los validadores (llamados «bakers») se eligen en función del número de Tezzies (XTZ) que poseen y apuestan. Cada validador recibe una recompensa proporcional a su compromiso, lo que incentiva tanto a participar activamente como a participar. actuar honestamente.

Para garantizar la integridad de la red, PoS incorpora un mecanismo llamado “slashingSlashing Se trata de un mecanismo de penalización en redes Proof of Stake en el que se retira una parte de los tokens staked por un validador por comportamiento fraudulento o por no cumplir con sus obligaciones.”. Este último penaliza a los validadores que actúan de forma maliciosa o negligente. Por ejemplo, si un validador intenta agregar transacciones fraudulentas o permanece inactivo cuando se supone que debe validar un bloque, algunos o todos los tokens que ha apostado pueden ser confiscados. Este sistema disuasorio fortalece la seguridad de la red al alinear los intereses económicos de los participantes con los del sistema.

Con Ethereum 2.0, donde se aplica reducción si un validador ofrece múltiples bloques en conflicto o no cumple con sus obligaciones, esto garantiza que solo los participantes serios y honestos sigan involucrados en el proceso.

Protocolos BFT modernos

Protocolos como Tendermint y Hotstuff han introducido importantes optimizaciones en el ámbito del consenso. El principio de rotación de líderes redistribuye periódicamente responsabilidades entre los participantes, fortaleciendo así la resiliencia del sistema. Estos protocolos también optimizaron la comunicación al reducir el volumen de mensajes requeridos y permitir el procesamiento paralelo de propuestas, lo que mejoró significativamente el rendimiento general de la red.

DeFiDeFi Los servicios DeFi utilizan contratos inteligentes, protocolos descentralizados y tokens para ofrecer una serie de servicios financieros que, en ocasiones, pueden sustituir a los ofrecidos por los bancos, como préstamos/empréstitos, gestión de activos, seguros o intercambio de activos. requiere mecanismos de consenso particularmente rápidos y justos. La finalidad de las transacciones debe ser casi instantánea, garantizando al mismo tiempo la protección contra la manipulación. Los protocolos deben funcionar de manera eficiente con dispositivos con recursos limitados y conexiones intermitentes, manteniendo al mismo tiempo la capacidad de escalar a millones de nodos.

¿Qué futuro tienen los mecanismos de consenso?

Su evolución refleja nuestro progreso hacia sistemas cada vez más distribuidos y autónomos. Los desafíos actuales (escalabilidad y eficiencia energética) están impulsando la innovación continua en esta área.

La investigación avanza hacia sistemas híbridos y adaptativos, capaces de combinar las ventajas de diferentes enfoques según el contexto. Este desarrollo podría conducir a una nueva generación de sistemas distribuidos que sean más eficientes, más seguros y más sostenibles, dando forma a la infraestructura digital del mañana.