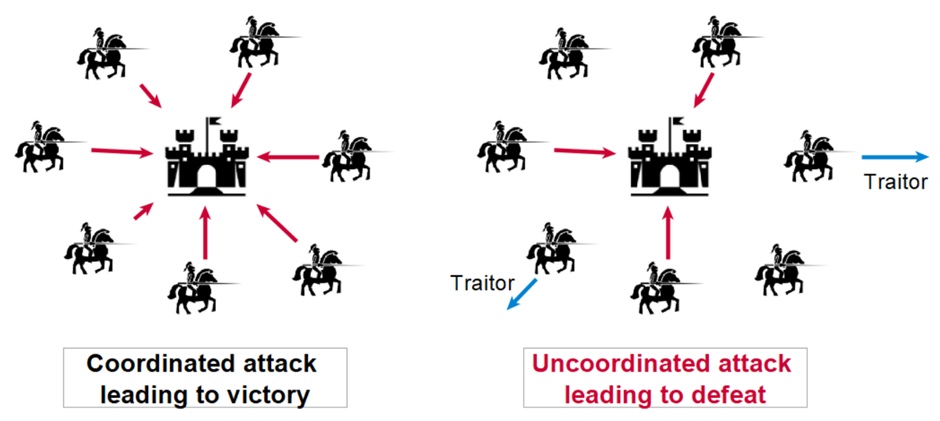

A história dos mecanismos de consenso começa com um problema fundamental na ciência da computação: o problema dos generais bizantinos.

Imagine vários generais que devem coordenar um ataque, mas só conseguem se comunicar por meio de mensageiros. Alguns generais podem ser traidores e os mensageiros podem ser interceptados. Como podemos garantir que todos os generais leais tomem a mesma decisão? Esta metáfora militar serve de base para ilustrar os desafios enfrentados pelos sistemas distribuídos modernos.

Os primeiros trabalhos sobre este problema, realizados na década de 1980, lançaram as bases teóricas para o que se tornaria uma área crucial da computação moderna. Leslie Lamport, pioneira neste campo, demonstrou que era impossível alcançar consenso de forma determinística em um sistema assíncrono, mesmo que um único nó pudesse falhar.

Anatomia de um consenso

Um mecanismo de consenso robusto deve garantir diversas propriedades essenciais:

- Todos os nós considerados “honestos” devem convergir para a mesma decisão. Esta propriedade é inviolável, mesmo em caso de partição de rede.

- O sistema deve continuar a progredir e a tomar decisões, mesmo na presença de falhas ou ataques.

- Uma vez tomada uma decisão, ela não poderá ser reconsiderada. Esta propriedade existe em duas formas: finalidade imediata e finalidade probabilística.

A finalidade imediata, que se encontra nomeadamente em protocolos do tipo BFT como o PBFT ou o Tendermint, garante que, uma vez validada pela rede, uma decisão é definitiva e não pode de forma alguma ser posta em causa.

Vejamos o exemplo de uma transação bancária: quando o seu banco confirma que uma transferência foi realizada, você quer ter certeza absoluta de que essa transação nunca será cancelada ou modificada. Esta forma de finalidade geralmente requer um processo de validação em várias etapas com votos explícitos dos participantes, como se, para tomar uma decisão importante, todos os membros de um conselho de administração tivessem que assinar um documento oficial.

A finalidade probabilística, utilizada em particular pelo Bitcoin e sistemas baseados em Prova de Trabalho, funciona de forma diferente. Neste caso, a certeza de que uma decisão é definitiva aumenta gradualmente ao longo do tempo. Tomando o exemplo do Bitcoin, quanto mais blocos forem confirmados após uma transação (falamos de “confirmações”), mais estatisticamente improvável se torna que esta transação seja posta em causa. É quase como se a confiança num acontecimento histórico aumentasse com o número de fontes independentes que o confirmam. Após seis confirmações em Bitcoin (cerca de uma hora), a probabilidade de ver uma transação questionada torna-se infinitamente baixa, mas nunca é teoricamente zero.

Modelos de tempo e falha

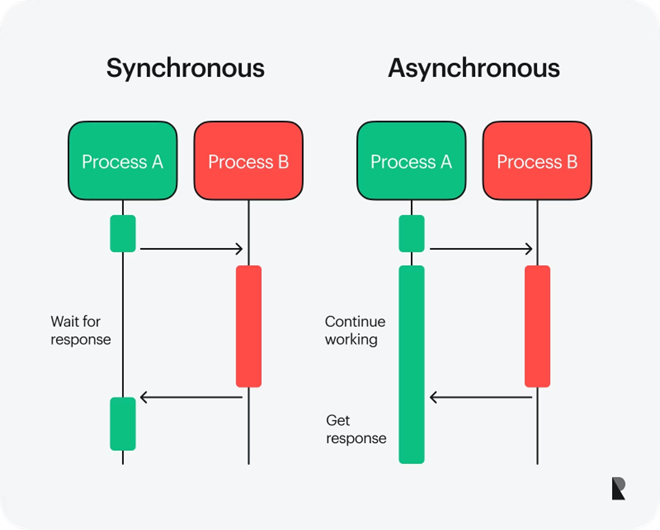

Os sistemas distribuídos dependem de diferentes modelos temporais que modificam sua arquitetura e operação. Num modelo síncrono, o sistema garante que cada mensagem será transmitida num intervalo de tempo preciso conhecido antecipadamente, o que facilita muito a concepção de protocolos, mas raramente se revela alcançável no contexto actual da Internet, onde os atrasos na transmissão são imprevisíveis.

Por outro lado, o modelo assíncrono adota uma abordagem mais próxima da realidade, não fazendo suposições sobre atrasos na transmissão de mensagens, tornando assim o projeto de protocolos mais complexo, mas mais robusto diante dos caprichos das redes reais. Entre estes dois extremos, o modelo parcialmente síncrono oferece um compromisso ao considerar que o sistema pode passar por fases onde se comporta de forma síncrona ou assíncrona, adaptando-se assim às mudanças nas condições da rede e permitindo ao mesmo tempo a concepção de protocolos eficientes.

Prova de Trabalho: a revolução Bitcoin

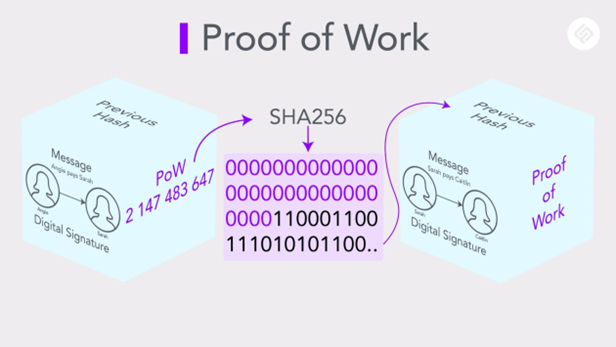

O PoW representa uma grande inovação porque resolve o problema do consenso num ambiente completamente aberto e hostil. Seu funcionamento é baseado em vários mecanismos sutis:

A Prova de Trabalho baseia-se em três mecanismos fundamentais que garantem a segurança e estabilidade da rede. No coração do sistema está uma função hashHash Uma função criptográfica que converte dados de entrada em uma cadeia alfanumérica de tamanho fixo. que não deve apenas resistir a ataques, mas também ter propriedades específicas que o tornam “amigável a quebra-cabeças” – o SHA-256 usado pelo Bitcoin é o exemplo perfeito. Para manter a regularidade da rede, um engenhoso sistema automático de ajuste de dificuldade intervém a cada 2016 blocos, permitindo manter um tempo médio de 10 minutos entre cada bloco, independentemente da potência computacional total da rede. Além disso, para gerir divergências temporárias que surgem numa rede descentralizada, o protocolo aplica a regra elegante da cadeia mais longa, que permite à rede convergir naturalmente para um consenso, favorecendo a cadeia que representa o maior trabalho cumulativo.

Prova de aposta, um novo paradigma

Em um sistema PoS, os validadores são escolhidos para verificar as transações e adicionar novos blocos ao blockchainBlockchain Um livro-razão público e imutável de transações criptográficas, organizado em blocos. com base na quantidade de tokens que eles apostaram. Quanto mais tokens apostados um participante tiver, maiores serão suas chances de ser selecionado. Por exemplo, no caso do Ethereum 2.0, um validador deve apostar pelo menos 32 ETH para participar do consenso. Uma vez selecionado, o validador verifica as transações do bloco e recebe uma recompensa na forma de novas criptomoedas ou taxas de transação.

Este processo é automatizado por algoritmos que selecionam os validadores de acordo com critérios pré-definidos. Esses critérios geralmente incluem:

- O valor apostado: Quanto mais tokens um usuário tiver, maior será a probabilidade de ele ser escolhido.

- Antiguidade: Alguns sistemas favorecem validadores que já participam da rede há muito tempo.

- Randomização: Para evitar centralização excessiva, às vezes são introduzidos elementos aleatórios no processo de seleção.

Um exemplo concreto é o da Tezos, onde os validadores (chamados “padeiros”) são escolhidos com base no número de Tezzies (XTZ) que possuem e apostam. Cada validador recebe uma recompensa proporcional ao seu compromisso, o que incentiva tanto a participação ativa como a participação. agir honestamente.

Para garantir a integridade da rede, o PoS incorpora um mecanismo denominado “slashingSlashing Um mecanismo de penalidade em redes Proof of Stake em que uma parte dos tokens apostados de um validador é retirada por comportamento malicioso ou falha no desempenho de suas funções.”. Este último penaliza os validadores que agem de forma maliciosa ou negligente. Por exemplo, se um validador tentar adicionar transações fraudulentas ou permanecer inativo quando deveria validar um bloco, alguns ou todos os tokens que ele apostou poderão ser confiscados. Este sistema dissuasor fortalece a segurança da rede, alinhando os interesses económicos dos participantes com os do sistema.

Com o Ethereum 2.0, onde a redução é aplicada se um validador oferecer vários blocos conflitantes ou não cumprir suas obrigações, isso garante que apenas participantes sérios e honestos permaneçam envolvidos no processo.

Protocolos BFT modernos

Protocolos como Tendermint e Hotstuff introduziram otimizações significativas na área de consenso. O princípio da rotação de líderes redistribui periodicamente as responsabilidades entre os participantes, fortalecendo assim a resiliência do sistema. Esses protocolos também otimizaram a comunicação, reduzindo o volume de mensagens necessárias e permitindo o processamento paralelo de propostas, melhorando significativamente o desempenho geral da rede.

DeFiDeFi Os serviços de DeFi usam smart contracts, protocolos descentralizados e tokens para oferecer uma gama de serviços financeiros que, às vezes, podem substituir os oferecidos pelos bancos, como empréstimos/empréstimos, gerenciamento de ativos, seguros ou troca de ativos. requer mecanismos de consenso particularmente rápidos e justos. A finalidade das transações deve ser quase instantânea, garantindo ao mesmo tempo proteção contra manipulação. Os protocolos devem operar de forma eficiente com dispositivos com recursos limitados e conexões intermitentes, mantendo ao mesmo tempo a capacidade de escalar para milhões de nós.

Que futuro para os mecanismos de consenso?

A sua evolução reflecte o nosso progresso em direcção a sistemas cada vez mais distribuídos e autónomos. Os desafios atuais (escalabilidade e eficiência energética) estão a impulsionar a inovação contínua nesta área.

A investigação avança para sistemas híbridos e adaptativos, capazes de combinar as vantagens de diferentes abordagens dependendo do contexto. Este desenvolvimento poderá levar a uma nova geração de sistemas distribuídos que sejam mais eficientes, mais seguros e mais sustentáveis, moldando a infraestrutura digital de amanhã.